Saisi en juillet 2023 par les bureaux de l’Assemblée nationale et du Sénat pour étudier les nouveaux développements de l’intelligence artificielle dans le contexte de la révolution de l’IA générative, l’office parlementaire sur les choix scientifiques a rendu son rapport qui tente, à la fois, de dresser un bilan des technologies d’intelligence artificielle et d’anticiper les tendances qui se dégagent.

Ce rapport retrace les développements technologiques des différents modèles d’IA et le détail de leur fonctionnement, identifie leurs enjeux politiques, économiques, sociétaux, culturels et scientifiques, et aborde les questions de régulation, comparant la stratégie nationale française en IA à près de 20 autres, six dans l’Union européenne et onze dans le reste du monde, et en analysant une dizaine de projets de gouvernance mondiale de l’intelligence artificielle. Il propose en conclusion 18 recommandations, dont cinq à soutenir dans le cadre du Sommet pour l’action sur l’IA (Paris les 10 et 11 février 2025).

La diffusion de l’intelligence artificielle, surtout de l’IA générative, permet de rendre automatisables nos tâches intellectuelles, et certaines de nos compétences dans le domaine de la création sont directement concurrencées.

Sommaire

LES RÉGIMES JURIDIQUES DE LA PROPRIÉTÉ INTELLECTUELLE

Les régimes juridiques de propriété intellectuelle existants font face à des défis qu’ils n’ont jamais rencontrés auparavant. Ils sont incapables, d’une part, de permettre la rémunération ou l’indemnisation des titulaires de droit sur les oeuvres ayant servi de sources aux modèles d’IA, d’autre part, de déterminer, pour l’heure, les règles applicables aux oeuvres créées par intelligence artificielle, dont le statut reste incertain.

En outre, l’automatisation des processus de création artistique est susceptible de modifier en profondeur l’ensemble des industries culturelles, en permettant aux studios de créer des contenus rapidement et à moindre coût.

1. Des régimes de propriété intellectuelle fragilisés

L’intelligence artificielle a d’ores et déjà un impact sur les régimes de propriété intellectuelle, aussi bien sur le droit d’auteur français que sur le copyright anglo-saxon, qui bien que convergents sur la forme depuis la convention de Berne de 1886 restent différents. En effet, il n’existe toujours pas de droit d’auteur au niveau international.

Pour mémoire, le droit d’auteur français considère une oeuvre comme une extension de la personnalité de son créateur, conférant un droit de propriété incorporel fort, qui englobe des attributs d’ordre intellectuel, moral et patrimonial.

Le droit moral est ainsi perpétuel, inaliénable et imprescriptible même si le droit patrimonial, d’une durée variable, a fait tomber l’oeuvre dans le domaine public.

En revanche, le copyright relève d’une logique strictement économique et accorde un droit moral restreint, qui se concentre principalement sur le support matériel de l’oeuvre et les intérêts financiers du titulaire du copyright (qui peut être l’auteur ou pas). Des modalités de régime juridique différentes peuvent également exister d’un pays à un autre.

Entraîner un modèle d’intelligence artificielle nécessite de grandes quantités de données, collectées de manière automatique à travers de vastes jeux de données, qui contiennent donc parfois tout ou partie d’oeuvres soumises au copyright ou au droit d’auteur.

Sans transparence de la part des développeurs de modèles de fondation, il est difficile de savoir exactement quelles oeuvres sont présentes au sein des données d’entraînement du modèle. Il est donc difficile pour un ayant droit de faire valoir ses droits pour atteinte au copyright ou au droit d’auteur.

Cela est d’autant plus problématique que la directive 2019/790 du 17 avril 2019 de l’Union européenne prévoit paradoxalement une possibilité pour les ayants droit de refuser (« opt-out ») que leurs oeuvres soient utilisées dans les bases de données d’IA. Un droit de retrait qui ne peut donc rester que formel.

Alexandra Bensamoun, professeure de droit à l’Université Paris-Saclay et spécialiste du droit d’auteur et de l’intelligence artificielle, a affirmé lors de son audition devant la commission de la culture, de l’éducation et de la communication du Sénat que l’on sait aujourd’hui que des modèles d’IA ont utilisé dans leurs données d’entraînement des données d’auteurs qui avaient pourtant d’ores et déjà fait valoir leur droit de retrait des bases de données.

L’absence de respect des règles relatives à la propriété intellectuelle est également reconnue par les représentants des grandes entreprises américaines de l’intelligence artificielle eux-mêmes. Ils ne se cachent pas de violer le droit d’auteur ou le copyright, dès lors que les oeuvres sont sur Internet. Ainsi, le directeur technique d’OpenAI, Mustafa Suleyman, a pu avouer :

« Je pense qu’en ce qui concerne le contenu qui se trouve déjà sur le Web ouvert, le contrat social de ce contenu depuis les années 1990 est l’utilisation équitable. Tout le monde peut le copier, le recréer, le reproduire. C’est ce que l’on appelle le “freeware” si l’on veut, et c’est ce que l’on a compris ».

Cette question relevant principalement du sujet des données utilisées, la Commission nationale de l’informatique et des libertés (Cnil) est directement concernée par ces questions. Lors de son audition par les rapporteurs, Bertrand Pailhès, directeur des technologies et de l’innovation à la Cnil et ancien coordinateur national pour l’intelligence artificielle, a rappelé que le règlement général pour la protection des données (RGPD) doit s’appliquer à l’entraînement des modèles d’intelligence artificielle.

Aussi, en théorie, la collecte de contenus ne peut se faire en provenance de sources manifestement illégales. La collecte de données doit en outre répondre à une finalité explicitement définie et s’appuyer sur une base légale, souvent l’intérêt légitime. La Cnil a constitué des « fiches pratiques » qui permettent d’assurer le respect de la protection des données lors de leur traitement par des systèmes d’IA, ce qui inclut donc, sans s’y limiter, la protection de la propriété intellectuelle.

La base de données d’entraînement du contenu illicite ?

Les législations françaises et européennes déterminent ainsi un cadre théorique assez clair pour le respect de la propriété intellectuelle et fixent des limites aux cas d’entraînement des modèles d’intelligence artificielle. Elles permettent de définir ce qui constitue des pratiques acceptables ou pas.

Cela est d’autant plus important qu’il semble que beaucoup d’entreprises développant des solutions d’intelligence artificielle semblent tentées de contourner ces principes. Ces discours se retrouvent en effet souvent dans le secteur du numérique, y compris du côté de figures emblématiques de la French Tech, comme Oussama Ammar, cofondateur de l’incubateur The Family avec Alice Zagury et Nicolas Colin, qui a souvent fait de la transgression des règles le coeur de ses conseils aux start-up en vue d’une innovation disruptive.

Néanmoins, fixer des règles définissant ce cadre légal n’est pas en soi suffisant, il faut également s’assurer de disposer des moyens permettant de contraindre les entreprises de respecter ce cadre.

Or, les sociétés font elles-mêmes valoir des principes de confidentialité qui contreviennent à cet objectif, ce qui pose un problème de transparence de l’information.

Il est quasi impossible pour les autorités ou pour un juge d’obtenir des informations sur les bases de données d’entraînement utilisées sans y avoir directement accès et il est donc très difficile de prouver, sur la seule base des résultats d’un modèle, que ce dernier contient dans sa base de données d’entraînement du contenu illicite. Et quand bien même le régulateur ou un juge aurait accès aux milliards de données utilisées, le tri pour identifier les oeuvres protégées resterait lui aussi très ardu.

Les entreprises développant des modèles de fondation considèrent, de plus, que les données collectées et leur traitement avant même l’entraînement (nettoyage/curation) constituent une source de valeur pour elles. Ouvrir ces données constituerait pour elles une perte d’avantages comparatifs vis-à-vis de leurs concurrents.

C’est cette position qu’ont tenue les responsables de MistralAI lors de leur audition devant les rapporteurs. Il y a donc un équilibre à trouver entre, d’une part, l’intérêt général et la préservation des intérêts des ayants droit, le régulateur ou les titulaires des droits devant pouvoir avoir accéder aux bases de données d’entraînement des modèles d’IA, et, d’autre part, les intérêts des entreprises développant les modèles d’IA pour qui ces données d’entraînement sont un élément de valeur en soi et une ressource indispensable pour l’entraînement des modèles.

Des risques contentieux

Dans ce contexte d’incertitudes, les risques contentieux sont de plus en plus grands, qu’il s’agisse de l’utilisation d’oeuvres protégées pour entraîner les modèles, de la protection des oeuvres générées par des systèmes d’IA ou, encore, de tout autre litige qui pourrait émerger. En l’absence de règles claires, il reviendra aux juges de trancher les litiges. Le rôle de la jurisprudence sera donc central et laisse les artistes, les entreprises et les utilisateurs dans un flou juridique anxiogène, avec des risques financiers qui ne sont pas négligeables.

C’est pourquoi une clarification de ces enjeux et des régimes juridiques applicables est indispensable. Le rapport d’information de la commission des lois de l’Assemblée nationale déposé en conclusion des travaux de sa mission d’information sur les défis de l’intelligence artificielle générative en matière de protection des données personnelles et d’utilisation du contenu généré fournit des pistes utiles à la réflexion.

Le modèle économique de la création artistique par l’IA

Par définition, le système de droit d’auteur se retrouve davantage fragilisé par l’apparition d’oeuvres générées par l’IA que le système de copyright.

En effet, le premier rattache l’oeuvre à son auteur avant de poser la question du titulaire du droit patrimonial. Or, la définition de l’auteur dans le cas d’une oeuvre créée par un modèle d’IA est difficile. Qui est l’auteur d’une oeuvre générée par IA ? L’auteur est-il le développeur du modèle de fondation, le distributeur de l’application d’IA générative, l’utilisateur qui a formulé une instruction ou, de manière plus complexe, l’ensemble des auteurs qui ont vu leurs oeuvres être utilisées pour l’entraînement du modèle et parvenir à l’oeuvre finale ?

Ces questions appellent à réfléchir à la notion même de droit d’auteur qui, s’il apparaît de moins en moins adapté, doit tout de même être sanctuarisé à l’heure de l’IA générative, fusse au prix d’importantes adaptations.

Les rapporteurs ont rencontré des artistes créateurs d’oeuvres utilisant l’IA : le collectif d’artistes Obvious, représenté par Pierre Fautrel, ainsi que Christophe Labarde, organisateur de l’exposition « Irruption – Quand l’intelligence artificielle bouleverse la création » au Château de Turenne. Pour mémoire, le collectif Obvious est notamment à l’origine de l’oeuvre générée par IA « La famille de Belamy », vendue aux enchères pour un prix de 432 000 dollars, ce qui a constitué un record.

Ces deux experts ont admis qu’il était trop difficile de déterminer si une oeuvre réalisée par l’IA était inspirée d’une oeuvre déjà existante, sauf à tomber dans la pure et simple copie, la contrefaçon étant déjà un délit puni par la loi

Une solution minimale pour réguler les créations par l’intelligence artificielle pourrait être l’application d’un filigrane sur les médias créés par des modèles d’intelligence artificielle (watermarking).

Ainsi, il serait possible de distinguer les oeuvres générées par des modèles d’IA et celles d’origine humaine. Une telle solution se heurte néanmoins à des problèmes pratiques : il faudrait que le filigrane ne soit pas trop visible afin de ne pas dénaturer l’oeuvre ; la modification de l’oeuvre ne devrait plus être possible après l’application du filigrane pour ne pas altérer ce dernier ou le faire disparaître ; il faudrait que le filigrane puisse être détecté sur différents supports, numériques et physiques. Restera en outre la question de savoir comment appliquer de tels filigranes à différents types d’oeuvres : textes, images, sons, musiques, vidéos en tout genre générés par intelligence artificielle.

Autant de défis qui feront l’identification concrète des oeuvres créées par des systèmes d’intelligence artificielle un sujet complexe et multidimensionnel, au moins à ce stade de l’état des connaissances et des techniques.

L’avenir de la création artistique

L’arrivée d’outils d’intelligence artificielle capables de générer du contenu artistique sur la base de données numériques, couplée à l’avènement du Big Data, sont des facteurs de transformation profonde de la création artistique et de l’ensemble des industries culturelles qui pourront créer du contenu plus rapidement, plus efficacement et à moindre coût grâce à l’IA générative, avec une offre plus personnalisée par l’analyse des données des utilisateurs.

Aux États-Unis, les rapporteurs ont rencontré Matthieu Lorrain et Surya Tubach, représentants de Google Creativ, la filiale de Google en charge des industries culturelles, qui leur ont parlé des initiatives prises par le géant du numérique en matière de création artistique. Ils affirment que le futur consistera par exemple à produire des « contenus liquides » (liquid content), à savoir des contenus adaptables aux préférences des utilisateurs grâce à des intelligences artificielles capables d’analyser toutes les données produites par les utilisateurs.

Face à un tel modèle économique et technique, il pourrait devenir difficile aux productions traditionnelles de rivaliser avec ces types de contenu spécifiquement conçus pour répondre aux attentes de chaque utilisateur. Il s’agirait alors d’un pas supplémentaire vers la marchandisation des industries culturelles, notamment audiovisuelles, en faisant notamment disparaître la vision d’auteur des films et des séries.

La perspective unique et très personnelle que peut apporter un réalisateur talentueux pourrait ne plus exister par exemple. Il ne s’agirait plus que de créer des contenus audiovisuels sur mesure, basés sur les « préférences » supposées des utilisateurs.

En plus de brider la créativité artistique, ce type de contenu conduirait paradoxalement à renforcer les bulles de filtres et mènerait à une plus grande uniformisation des films et des séries, limitées à une déclinaison de tropes narratifs populaires moyens ajustés à l’aide d’artefacts superficiels de personnalisation basés sur les préférences supposées du spectateur.

Une telle évolution cloisonnerait encore davantage chacun dans un univers culturel aux perspectives restreintes et aux contenus appauvris. Avant même le recours généralisé à l’IA, les contenus et les recommandations de plateformes audiovisuelles telles que Netflix vont déjà en partie dans ce sens.

De telles transformations profondes de la création artistique et des industries culturelles entraîneront de manière très probable une forte conflictualité sociale, comme l’ont montré les longues grèves de syndicats de scénaristes aux États-Unis, soutenues par différentes corporations d’artistes, dont celle des acteurs.

La grève de la Writers Guild of America en 2023 avec ses 11 500 scénaristes face à l’Alliance of Motion Picture and Television Producers a ainsi duré du 2 mai au 27 septembre 2023, ce qui est historique.

UNE POLITIQUE FRANÇAISE DE L’INTELLIGENCE ARTIFICIELLE EN DEMI-TEINTE

La stratégie nationale en faveur de l’IA depuis 2017 : un retard à l’allumage

Des stratégies nationales ambitieuses pour le secteur numérique ont déjà été définies par le passé. Le « Plan Calcul », lancé en 1966, le rapport sur l’informatisation de la société publié en 1978, qui a inventé le concept de télématique et proposé le lancement du réseau Minitel, le plan « Informatique pour tous » impulsé en 1985, le rapport sur les autoroutes de l’information en 1994 ou encore le programme d’action gouvernemental pour la société de l’information (PAGSI) et les espaces publics numériques (EPN) en 2000, en sont différents exemples qui ont souvent laissé des souvenirs doux-amers en raison de leurs résultats qui n’étaient pas à la hauteur des espoirs suscités.

En France, le pouvoir exécutif a depuis 2017, sans directement réguler l’intelligence artificielle, annoncé des stratégies nationales pour l’IA et mis en place une série de mesures concernant la gouvernance de l’IA. Refaire l’histoire de cette succession d’annonces ou de mesures dans le domaine des technologies d’intelligence artificielle est indispensable avant de pouvoir dessiner des perspectives pour le futur.

Une première stratégie nationale pour l’IA a été voulue par le Président de la République, alors François Hollande, dès janvier 2017, en écho à la stratégie américaine dévoilée en octobre 2016 par le président américain Barack Obama.

La secrétaire d’État chargée du numérique et de l’innovation, Axelle Lemaire, avait ainsi été missionnée pour préparer les détails de ce plan baptisé « France IA », lancé dans l’incubateur Agoranov le 20 janvier 2017 et ayant conduit à la remise d’un rapport au Président de la République à la Cité des Sciences et de l’industrie le 21 mars 2017.

Ce plan visait notamment à mettre en place un comité de pilotage « France IA », à financer de nouveaux projets de recherche en IA à travers le programme pour les investissements d’avenir (PIA), à créer un centre interdisciplinaire sur l’IA, à réaliser une cartographie de l’écosystème de l’intelligence artificielle en France en vue de mobiliser les acteurs publics et privés, à réfléchir à des normes et des standards, et à suivre l’impact de l’IA sur l’économie et la société.

En parallèle de ce plan gouvernemental, dès le printemps 2016, la sénatrice Dominique Gillot et le député Claude de Ganay ont préparé le premier rapport de l’OPECST sur l’intelligence artificielle. Publié le 15 mars 2017, ce rapport présentait 15 propositions au nom de l’Office. Ses auteurs y regrettaient qu’en raison de l’actualité, le plan France IA arrive trop tard pour pouvoir être réellement pris en compte dans les politiques publiques.

Le plan France IA du Gouvernement a ensuite été suspendu puis a été purement et simplement enterré : il n’a pu en effet être mis en oeuvre dans le contexte des élections présidentielles de 2017 et de l’élection d’Emmanuel Macron à la tête de l’État.

Ce dernier a préféré retravailler une nouvelle stratégie pour l’intelligence artificielle durant son premier mandat, qu’il annoncerait lui-même : un an plus tard c’est avec la remise d’un autre rapport émanant du président de l’Office, notre ancien collègue député Cédric Villani, alors en mission pour l’exécutif, que le Président de la République a pu proposer au Collège de France, le 29 mars 2018, en présence de la ministre allemande de la recherche et du commissaire européen à l’innovation, une « Stratégie nationale et européenne pour l’intelligence artificielle », lors d’un événement baptisé « AI for Humanity »

Rétrospectivement, cette approche semblait se préoccuper insuffisamment de l’innovation technique en IA, le rapport de notre ancien collègue était d’ailleurs exclusivement tourné vers les technologies de Deep Learning en vogue à l’époque et appelait essentiellement à centrer les efforts de notre stratégie en matière d’intelligence artificielle sur leur déploiement dans certains domaines d’application comme les transports, la santé, la sécurité, l’environnement et la défense.

En matière de santé, il proposait par exemple d’interconnecter les fichiers déjà existants pour développer ce qui est devenu le Health Data Hub.

Avec un financement pluriannuel d’1,5 milliard d’euros annoncé, la stratégie nationale pour l’IA ambitionnait de faire de la France un des leaders mondiaux de l’intelligence artificielle.

Or, elle a surtout consisté dans la labellisation de quatre instituts interdisciplinaires d’intelligence artificielle (3IA), le financement de chaires et de doctorats ou encore l’investissement indispensable dans des infrastructures de calcul à travers des supercalculateurs gérés par le GENCI (pour Grand équipement national de calcul intensif) comme Jean Zay, inauguré en 2019, ou Adastra, inauguré en 2023, et dont les performances atteignent respectivement 36,85 pétaflops et 74 pétaflops (Jean Zay devrait toutefois atteindre 125,9 pétaflops cette année). Pour mémoire un pétaflop représente un million de milliards de calculs d’opérations en virgule flottante par seconde.

Il faut noter que ces deux supercalculateurs n’étant plus au niveau exascale des standards internationaux, c’est-à-dire dépassant un exaflop par seconde (un milliard de milliards de calculs par seconde), la France va héberger un supercalculateur européen (qui devait s’appeler Jules Verne mais portera finalement le nom de la chercheuse oubliée Alice Recoque) dont elle devra partager l’usage avec l’Union européenne.

À titre de comparaison, l’entreprise d’Elon Musk spécialisée en IA, appelée « xAI » et qui développe le système Grok, s’est engagée à acheter entre 3 et 4 milliards de dollars de GPU à Nvidia et s’est dotée d’un supercalculateur de 150 MW du nom de Colossus, construit en 19 jours, développant théoriquement 3,4 exaflops par seconde, car composé de 100 000 processeurs Nvidia Hopper 100. Sa taille devrait doubler d’ici quelques mois pour atteindre 200 000 processeurs.

Pour mémoire, Google, OpenAI, Microsoft, Meta et Nvidia étaient les seules entreprises au monde à dépasser les 50 000 GPU et xAI vient de repousser la frontière du concevable avec la perspective de cette structure de 200 000 processeurs GPU. Les puces utilisées, les Nvidia Hopper H100, ont un coût unitaire qui varie de 30 000 à 70 000 dollars, un coût du même ordre que la nouvelle génération de puces Nvidia, les Blackwell B200, dont les rapporteurs ont pu voir le format réduit au siège de Nvidia, et qui seront commercialisées prochainement.

Les 200 000 processeurs de xAI ont une valeur comprise entre 6 et 14 milliards de dollars environ. Le supercalculateur Jean Zay, après son extension prévue d’ici la fin de l’année 2024, sera quant à lui doté de 1 456 GPU Nvidia H100.

La stratégie nationale pour l’intelligence artificielle, divisée en deux phases, a également conduit à une coordination qui n’a d’interministérielle que le nom avec un coordinateur rattaché initialement à la direction interministérielle du numérique et du système d’information et de communication (DINSIC), puis à la direction générale des entreprises (DGE) du ministère de l’économie, sans autorité réelle sur les conditions de mise en oeuvre de la stratégie.

L’instabilité du titulaire de cette fonction et les vacances répétées du poste sont également frappantes : Bertrand Pailhès nommé en juillet 2018, quitte ses fonctions un an plus tard en novembre 2019, il n’est remplacé par Renaud Vedel qu’en mars 2020, qui ne reste chargé de cette mission que jusqu’à l’été 2022, Guillaume Avrin ne rejoint la structure qu’en janvier 2023, à nouveau après une vacance de six mois. Cette instabilité et ces vacances révèlent une fonction problématique et mal définie.

Au total, le pilotage de la stratégie nationale en IA reste toujours défaillant : elle demeure d’ailleurs en réalité toujours sans pilote, évoluant au gré des annonces du Président de la République, à l’instar de son courrier du 25 mars 2024 faisant d’Anne Bouverot « l’envoyée spéciale du Président de la République » pour le futur sommet sur l’IA ou de son discours lors du rassemblement des plus grands talents français de l’IA à l’Élysée le 21 mai 2024, qui présentait les nouveaux cinq grands domaines de la stratégie nationale pour l’IA.

Le bilan critique de la stratégie et son évaluation par la Cour des comptes

La première étape de la stratégie nationale pour l’IA mise en place par l’exécutif à partir de 2018 a déjà pu être évaluée et les effets produits par les mesures prises ont pu être comparés à leurs effets escomptés.

La Cour des comptes a ainsi publié, en avril 2023, un rapport qui dresse le bilan de la stratégie mise en place par l’exécutif concernant l’intelligence artificielle. Elle évalue en particulier les mesures prises et leurs effets par rapport aux objectifs fixés par le Président de la République lors de la mise en place de ce plan : positionner la France parmi les cinq meilleurs pays en termes d’IA, et devenir les chefs de file européens dans le domaine.

L’évaluation est plutôt mitigée. En effet, loin d’atteindre les objectifs affichés, comme celui de devenir un leader mondial, il semble que la stratégie nationale pour l’IA ait surtout permis à la France de ne pas décrocher davantage dans la compétition au niveau mondial, au moins dans les quelques domaines investis par le plan.

La Cour des comptes affirme ainsi que la priorité donnée à la recherche en IA a permis à la France de maintenir un niveau honorable en termes de publication d’articles scientifiques et d’efficience de la recherche.

Ce résultat est cependant à relativiser puisque lorsque ces classements sont rapportés au PIB, la position de la France chute au 44e rang : « Si la France apparaît assez performante en matière de recherche en IA (10e rang mondial et 2e rang européen en 2021 en nombre de publications en IA sur un total de 47 pays comparés), sa recherche dans ce domaine apparaît peu efficiente au regard du produit intérieur brut de la France (44e rang mondial et 25e européen en 2021 pour le même critère rapporté au PIB). »

La mise en place des Instituts 3IA est jugée plutôt efficace par le rapport, qui constate que ces instituts contribuent à l’augmentation du nombre de publications scientifiques et de coopérations internationales en matière d’IA. Ceci est permis grâce à des collaborations interdisciplinaires et à l’acquisition de ressources technologiques avancées. Un exemple est l’acquisition de noeud de clusters GPU par le 3IA de Nice Sophia-Antipolis pour renforcer ses capacités de calcul ; il est mis à disposition en priorité pour les chaires 3IA.

Le rapport note toutefois que les résultats des Instituts 3IA ne sont pas à la hauteur des attentes initiales. D’après la Cour des comptes, la cartographie des formations en IA, loin d’être homogène, est complexe et peu lisible. De plus, les instituts 3IA ne sont pas autonomes et apparaissent précaires : la pérennité des financements de l’État est cruciale pour maintenir la dynamique de ces instituts, or la visibilité des perspectives financières est très réduite.

En raison de ce contexte global, le rapport juge que la formation des talents en IA, même si elle a progressé, reste encore très insuffisante pour combler le déficit de compétences en intelligence artificielle dans le pays. Les rapporteurs ajoutent que rien n’a non plus été fait pour lutter contre la fuite des cerveaux.

S’agissant de la gouvernance et des investissements en IA, la complexité de l’écosystème d’acteurs et des outils de financement public constitue un frein à l’efficacité des mesures voulues par l’exécutif, et ce, malgré la présence du coordinateur national à l’intelligence artificielle (aujourd’hui Guillaume Avrin). Cette coordination ne joue pas un rôle assez important et n’est pas assez financée selon la Cour.

Ce déficit de cohérence dans la gouvernance française de sa stratégie en IA crée des difficultés pour attirer et concentrer les investissements. Aussi, bien que les sommes investies représentent des montants importants, la dispersion des moyens dans un saupoudrage peu rationnel empêche ces investissements d’être pleinement efficaces.

Aussi, la Cour des comptes préconise l’élaboration d’une nouvelle politique publique globale en matière d’IA, au moins pour assurer une bonne gouvernance et une coordination de l’ensemble des dispositifs de financement.

Les perspectives de relance de la politique nationale de l’IA

La dernière étape concernant la gouvernance française de l’intelligence artificielle a été la remise au Gouvernement du rapport « IA : notre ambition pour la France » le 13 mars 2024

Ce rapport a été rédigé par la Commission de l’intelligence artificielle dont les présidents étaient Anne Bouverot et Philippe Aghion, rencontrés par les rapporteurs, tout comme l’ont été les deux rapporteurs généraux du rapport, Cyprien Canivenc et Arno Amabile.

Ce rapport important contient 25 recommandations pour une politique ambitieuse de la France en matière d’IA, avec un investissement d’un peu plus de cinq milliards d’euros par an sur cinq ans. Ces dépenses évaluées à 27 milliards d’euros au total sont récapitulées ci-après.

Tableau récapitulatif des recommandations de la Commission de l’intelligence artificielle

| Recommandations | Coût estimé sur cinq ans | |

| 1 | Créer les conditions d’une appropriation collective de l’IA et de ses enjeux afin de définir collectivement les conditions dans lesquelles elle s’insère dans notre société et nos vies quotidiennes | 10 millions d’euros |

| 2 | Investir dans l’observation, les études et la recherche sur les impacts des systèmes d’IA sur la quantité et la qualité de l’emploi | 5 millions d’euros |

| 3 | Faire du dialogue social et professionnel un outil de co-construction des usages et de régulation des risques des systèmes d’IA | – |

| 4 | Porter une stratégie de soutien à l’écosystème d’IA ouverte au niveau international en soutenant l’utilisation et le développement de systèmes d’IA ouverts et les capacités d’inspection et d’évaluation par des tiers | – |

| 5 | Faire de la France un pionnier de l’IA en renforçant la transparence environnementale, la recherche dans des modèles à faible impact, et l’utilisation de l’IA au service des transitions énergétique et environnementale | 100 millions d’euros |

| 6 | Généraliser le déploiement de l’IA dans toutes les formations d’enseignement supérieur et acculturer les élèves dans l’enseignement secondaire pour rendre accessibles et attractives les formations spécialisées | 1,2 milliard d’euros |

| 7 | Investir dans la formation professionnelle continue des travailleurs et dans les dispositifs de formation autour de l’IA | 200 millions d’euros |

| 8 | Former les professions créatives à l’IA, dès les premières années de l’enseignement supérieur et en continu | 20 millions d’euros |

| 9 | Renforcer la capacité technique et l’infrastructure du numérique public afin de définir et de passer à l’échelle une réelle transformation des services publics grâce au numérique et à l’IA, pour les agents et au service des usagers | 5,5 milliards d’euros |

| 10 | Faciliter la circulation des données et le partage de pratiques pour tirer les bénéfices de l’IA dans les soins, améliorer l’offre et le quotidien des soignants | 3 milliards d’euros |

| 11 | Encourager l’utilisation individuelle, l’expérimentation à grande échelle et l’évaluation des outils d’IA pour renforcer le service public de l’éducation et améliorer le quotidien des équipes pédagogiques | 1 milliard d’euros |

| 12 | Investir massivement dans les entreprises du numérique et la transformation des entreprises pour soutenir l’écosystème français de l’IA et en faire l’un des premiers mondiaux | 3,6 milliards d’euros |

| 13 | Accélérer l’émergence d’une filière européenne de composants semi-conducteurs adaptés aux systèmes d’IA | 7,7 milliards d’euros |

| 14 | Faire de la France et de l’Europe un pôle majeur de la puissance de calcul installée | 1 milliard d’euros |

| 15 | Transformer notre approche de la donnée personnelle pour mieux innover | 16 millions d’euros |

| 16 | Mettre en place une infrastructure technique favorisant la mise en relation entre les développeurs d’IA et les détenteurs de données culturelles patrimoniales | 35 millions d’euros |

| 17 | Mettre en oeuvre et évaluer les obligations de transparence prévues par le règlement européen sur l’IA en encourageant le développement de standards et d’une infrastructure adaptée | – |

| 18 | Attirer et retenir des talents de stature internationale avec des compétences scientifiques ou entrepreneuriales et managériales dans le domaine de l’IA | 10 millions d’euros |

| 19 | Assumer le principe d’une « Exception IA » sous la forme d’une expérimentation dans la recherche publique pour en renforcer l’attractivité | 1,025 milliard d’euros |

| 20 | Inciter, faciliter et amplifier le recours aux outils d’IA dans l’économie française en favorisant l’usage de solutions européennes | 2,6 milliards d’euros |

| 21 | Faciliter l’appropriation et l’accélération des usages de l’IA dans la culture et les médias pour limiter la polarisation entre grands groupes et petits acteurs et lutter contre la désinformation | 60 millions d’euros |

| 22 | Structurer une initiative diplomatique cohérente et concrète visant la fondation d’une gouvernance mondiale de l’IA | 300 millions d’euros |

| 23 | Structurer dès maintenant un puissant écosystème national de gouvernance de l’IA | 5 millions d’euros |

| 24 | Doter la France et l’Europe d’un écosystème d’évaluation public et privé des systèmes d’IA au plus proche des usages et des derniers développements technologiques | 15 millions d’euros |

| 25 | Anticiper les concentrations de marché sur l’ensemble de la chaîne de valeur de l’intelligence artificielle | – |

| TOTAL | 27 milliards d’euros | |

Les principaux leviers d’action actuels de l’exécutif sont ceux de la deuxième phase de la stratégie nationale pour l’intelligence artificielle (2021-2025), ainsi que les compléments apportés à cette stratégie par les mesures annoncées par le Président de la République lors du « rassemblement des plus grands talents français de l’IA » à l’Élysée le 21 mai 2024.

Lors de son audition par les rapporteurs, Guillaume Avrin, coordinateur national pour l’IA, a détaillé la structure du dispositif mis en place pour favoriser l’IA dans notre pays. Il a précisé que le plan de l’exécutif se découpait en plusieurs phases. La première phrase, aujourd’hui terminée consistait d’abord à promouvoir une IA d’excellence notamment grâce à la création des Instituts 3IA. Le second volet, en cours de déploiement, censé couvrir la période 2021-2025, consiste à diffuser l’IA dans l’économie et la société à l’aide de trois moyens d’investissement : la commande publique, les subventions et l’investissement en capital.

Le développement de cette deuxième phase vise spécifiquement quatre domaines : l’IA frugale, soit l’IA compétitive tout en étant écologiquement responsable, l’IA embarquée, c’est-à-dire des systèmes pouvant être exécutés localement, l’IA de confiance et l’IA générative, des aspects thématiques bien plus mis en avant que lors de la première phase. Le souhait de l’exécutif est de développer l’interdisciplinarité pour l’IA en promouvant l’initiative « l’IA plus X », c’est-à-dire l’utilisation de l’IA comme outil dans divers secteurs. L’approche applicative semble donc très privilégiée par le gouvernement, ce qui a été confirmé par l’audition de la DGE.

Lors du rassemblement des plus grands talents français de l’IA à l’Élysée le 21 mai 2024, le Président de la République, Emmanuel Macron, a indiqué qu’il souhaitait voir la stratégie en matière d’IA se déployer autour de cinq grands domaines : les talents, les infrastructures, les usages, l’investissement et la gouvernance. Une telle approche est plus satisfaisante qu’une concentration sur les seules applications.

Il a annoncé un plan d’investissement de 400 millions d’euros pour financer neuf pôles d’excellence en IA, comprenant les quatre anciens Instituts 3IA lancés en 2019 (MIAI@Grenoble-Alpes, 3IA Côte d’Azur, PRAIRIE et ANITI) auxquels s’ajoutent désormais SequoIA à Rennes, un projet de l’université de Lorraine, Hi Paris! de l’Institut polytechnique de Paris, PostGenAI@Paris de la Sorbonne et DATA IA de l’Université Paris-Saclay, l’objectif étant de passer de 40 000 à 100 000 personnes formées à l’IA par an.

Un autre projet annoncé par le chef de l’État est « Scribe » d’une durée prévue de deux ans, inclus dans le plan France 2030 et visant à soutenir l’IA sectorielle. Ce plan vise à encourager le développement de modèles de fondation et des applications sectorielles de l’IA, la création de jeux de données d’alignement sectoriels et le développement d’outils d’évaluation et de sécurité.

Un nouveau fonds d’investissement devrait être mis en place, dont un quart sera financé par l’État afin de financer des domaines aujourd’hui moins en vue, voire oubliés, bien que pourtant indispensables à l’IA, comme la filière des semi-conducteurs et des puces ainsi que l’informatique en nuage. Cet aspect est à suivre de près.

Le Président de la République a dans le même temps annoncé vouloir créer des fonds d’investissement similaires au niveau européen avec le même objectif de financement de ces secteurs stratégiques. Il faut espérer qu’une telle démarche ne conduise pas à prendre encore davantage de retard dans la mise en oeuvre d’un financement urgent et ciblé en direction de la filière française des semi-conducteurs et des puces ainsi que de l’informatique en nuage.

Le Président de la République a également prévu de doter le Conseil national du numérique de 10 millions d’euros supplémentaires pour lui permettre de réaliser sa mission d’acculturation des citoyens à l’IA, notamment à travers les « Cafés IA », proposés par la commission de l’intelligence artificielle.

Enfin, l’ouverture du centre d’évaluation en IA au sein du Laboratoire national de métrologie et d’essai (LNE) confirme le rôle important joué par cette structure dans le suivi et l’évaluation des modèles d’IA, en lien avec les exigences posées par l’AI Act de l’UE en 2024. Ce texte prévoit en effet un cadre assez précis en la matière.

18 recommandations complémentaires sur l’IA

En plus des recommandations générales concernant les nouveaux développements de l’intelligence artificielle, les rapporteurs ont également des recommandations plus spécifiquement destinées au Président de la République et aux organisateurs du futur sommet des 10 et 11 février 2025 de l’intelligence artificielle. Ces recommandations visent à s’assurer qu’une vision française éclairée de l’intelligence artificielle pourra s’exprimer à travers ce sommet.

Les rapporteurs ont élaboré 18 recommandations, dont cinq sont consacrées à la préparation du prochain sommet sur l’intelligence artificielle que la France organisera les 10 et 11 février 2025. Ils ont choisi de limiter le nombre de préconisations de manière à pouvoir communiquer plus efficacement. Ils demandent au gouvernement et au Président de la République de traduire ces recommandations en mesures effectives rapidement opérationnelles.

LES PROPOSITIONS À SOUTENIR DANS LE CADRE DU FUTUR SOMMET DE L’IA

1. Faire reconnaître le principe d’une approche transversale de l’IA et renoncer à l’approche exclusivement tournée vers les risques

La France doit profiter de l’organisation du prochain sommet pour contribuer à établir, selon une approche transversale, un cadre international de référence pour la future gouvernance mondiale des systèmes d’intelligence artificielle. Les sommets pour la sécurité de l’intelligence artificielle (AI safety summits) se sont tenus à la suite d’une initiative britannique visant à anticiper et encadrer les risques de l’intelligence artificielle dont les risques existentiels, il faut maintenant aller plus loin.

Le Sommet pour l’action sur l’IA des 10 et 11 février 2025 doit avoir le souci d’élargir les problématiques abordées et de poser les jalons de cette gouvernance mondiale. C’est pourquoi au-delà de la sécurité, il faut mettre à profit le fait que cinq thèmes essentiels seront l’objet du sommet (l’IA au service de l’intérêt public avec la question des infrastructures ouvertes ; l’avenir du travail ; la culture ; l’IA de confiance ; la gouvernance mondiale de l’IA) pour faire accepter au plus haut niveau le principe d’une approche transversale des enjeux de l’IA, qui devra se matérialiser solennellement dans une déclaration finale des participants.

La France étant chargée de l’organisation du sommet, elle pourra non seulement élargir ponctuellement les problématiques et les perspectives du travail collectif mais surtout consacrer cette logique multidimensionnelle des problématiques de l’IA. Les interrogations sur les risques existentiels de l’IA, dont la concrétisation reste très incertaine, ne doivent pas prendre une part trop grande au sein de cet événement international et des futurs sommets : il convient plutôt de se préoccuper d’enjeux plus directs. En effet, les systèmes d’intelligence artificielle présentent d’ores et déjà des risques réels et certains.

L’Office a déjà eu l’occasion de consacrer plusieurs travaux à ce sujet, notamment son rapport pionnier de 2017, où il se prononçait en faveur d’une intelligence artificielle maîtrisée, utile et démystifiée, prônant l’usage éthique d’algorithmes sûrs, transparents et non discriminatoires. Il y réclamait une politique publique de l’intelligence artificielle permettant la diffusion de ces technologies dans l’économie et la société française, à travers une politique de formation initiale et continue ambitieuse, une vigilance à l’égard de la domination par la recherche privée et les entreprises américaines et l’organisation de grands débats publics évoluant en fonction de l’état de l’art de la recherche en la matière.

Nous estimons à cet égard que les cinq thèmes retenus pour le prochain sommet de l’IA éludent deux dimensions à prendre en compte de manière prioritaire :

– l’éducation, qui pourrait être ajoutée à la verticale « culture » avec pour intitulé « éducation et culture » ;

– la souveraineté numérique, qui pourrait être ajoutée à la verticale « l’IA au service de l’intérêt public » avec pour intitulé « souveraineté numérique et intérêt général ».

2. Proposer de placer la gouvernance mondiale de l’IA sous l’égide d’une seule organisation internationale

Ce sommet doit être l’occasion d’apporter un minimum de clarification et de rationalisation dans la dizaine de projets de gouvernance mondiale de l’IA, c’est pourquoi il est proposé de placer la gouvernance mondiale de l’IA sous l’égide d’une seule organisation internationale, à savoir l’ONU, seule organisation pleinement légitime sur le plan multilatéral.

L’importance et la spécificité du sujet invitent à créer une nouvelle institution spécialisée membre du système des Nations unies, dont les compétences s’étendraient de la coordination internationale de la régulation de l’IA à la lutte contre la fracture numérique mondiale, plutôt qu’à confier ces responsabilités à une agence internationale déjà existante.

Ce serait la suite logique du Pacte numérique mondial, du comité scientifique international sur l’IA et du dialogue mondial sur la gouvernance de l’IA que les Nations unies ont mis en place, en septembre 2024.

Il s’agit aussi de l’une des propositions formulées par plusieurs chercheurs qui ont évoqué différentes pistes de gouvernance internationale de l’IA. L’approche de l’OCDE doit nourrir le travail de cette future organisation internationale de l’IA.

3. Initier le cadre d’une régulation globale et multidimensionnelle de l’IA en s’inspirant des travaux de l’OCDE et de l’UE

L’approche de la régulation mondiale de l’IA doit être multidimensionnelle, ainsi que le présent rapport dans ses développements sur la chaîne de valeur de l’IA ou, différemment, les travaux de l’OCDE le prévoient. L’OCDE ne reprend pas l’idée de chaîne de valeur telle qu’elle est développée dans le présent rapport mais elle propose de distinguer la multidimensionnalité de l’IA selon plusieurs phases.

Puisque les modèles d’IA se décomposent en au moins quatre phases distinctes et interdépendantes (l’OCDE retient : le contexte, les données d’entrées, les modèles eux-mêmes et les tâches demandées qui engendrent les sorties de l’IA), toutes les politiques publiques de régulation de ces technologies devraient prendre en compte la complexité de la chaîne de valeur de l’IA ou cette multidimensionnalité lors de la définition et de la mise en oeuvre de règles relatives à l’IA. Les dimensions en jeu aux stades de la conception, de l’entraînement, des réglages ou encore de l’utilisation des modèles d’intelligence artificielle sont autant d’objets qui justifient une prise en compte spécifique par la régulation.

4. Annoncer un programme européen de coopération en IA, associant plusieurs pays dont au moins la France, l’Allemagne, les Pays-Bas, l’Italie et l’Espagne

Il faut profiter du sommet pour annoncer le lancement d’un grand programme européen de coopération en IA. Une telle démarche, envisagée depuis 2017, n’a toujours pas connu de traductions concrètes. Cette initiative n’a pas nécessairement à réunir l’ensemble des 27 États membres, mais au moins la France, l’Allemagne, les Pays-Bas, l’Italie et l’Espagne.

Ces pays partagent une vision assez proche de l’IA et de ses enjeux, y compris l’adoption de l’IA dans le monde du travail et les objectifs d’aide aux PME et aux start-up. Il y a déjà eu des discussions sur l’IA entre la France et l’Allemagne ou entre la France et l’Italie, mais il reste à construire un programme de coopération marquant l’existence d’une voie européenne de l’IA spécifique allant plus loin que le soutien à l’innovation ou la régulation prévue par l’AI Act, une approche basée sur l’éthique et la prise en compte des conséquences à court, moyen et long termes de ces technologies.

Pour les rapporteurs, l’IA ouvre un espace d’opportunités qui peut nous aider à aller vers des sociétés solidaires soucieuses d’usages des technologies conformes aux droits de l’homme et aux valeurs humanistes. C’est un choix politique qui permettra d’éviter les seuls usages capitalistes, sécuritaires et oppressifs de ces technologies.

5. Associer le Parlement à l’organisation du sommet

Afin de garantir une plus grande légitimité du futur sommet, il est nécessaire d’associer plus étroitement le Parlement à son organisation.

La nomination d’un sénateur et d’un député au sein du comité de pilotage du sommet serait à cet égard un gage important de crédibilité, marquant la volonté de l’exécutif d’accroître le fondement démocratique de la réflexion française sur l’encadrement de l’IA à l’échelle internationale.

6. Développer une filière française ou européenne autonome sur l’ensemble de la chaîne de valeur de l’intelligence artificielle

La première de nos propositions au niveau national est un objectif qui doit tous nous mobiliser, pouvoirs publics nationaux et locaux, décideurs économiques, associations et syndicats : nous devons viser le développement d’une filière française ou européenne autonome sur l’ensemble de la chaîne de valeur de l’intelligence artificielle, même sans chercher à rivaliser avec les puissances américaines et chinoises en la matière. En effet, mieux vaut une bonne IA chez soi qu’une très bonne IA chez les autres. Il s’agit de se protéger par la maîtrise de l’ensemble des couches de la technologie.

Que ce soit au niveau européen, par l’UE ou avec une coopération renforcée entre quelques pays, ou directement au niveau national, la France doit relever ce défi de construire pour elle, en toute indépendance, les nombreux maillons de la chaîne de valeur de l’intelligence artificielle. L’enjeu de la souveraineté nationale sur cette chaîne est crucial, c’est une condition à la fois de notre indépendance en général et d’une véritable autonomie stratégique sur ces technologies d’IA. Lorsqu’une maîtrise complète de la chaîne ne sera pas possible, notre pays pourra se tourner vers ses partenaires européens pour construire les coopérations nécessaires.

Un article récent de dirigeants de Mc Kinsey, publié le 31 octobre 2024 dans Les Échos se prononce également en faveur « d’une stratégie holistique pour couvrir l’ensemble de la chaîne de valeur de la technologie » en Europe, de l’énergie jusqu’aux applications en passant par les semi-conducteurs, les infrastructures et les modèles. L’Europe est aujourd’hui leader dans un seul des segments de la chaîne de valeur de l’IA, celui très précis de la gravure des puces, et ce grâce à ASML. Cet article, sans y faire référence explicitement, repose sur le constat dressé dans une note du Mc Kinsey Global Institute d’octobre 2024 analysant la place des pays européens dans chacun des maillons de la chaîne de valeur de l’IA.

En dehors de la niche très spécifique d’ASML, les entreprises européennes restent dans la course en matière de conceptions des modèles, d’applications d’IA et de services mais elles ne représentent que moins de 5 % de parts de marché pour les matières premières (silicium en particulier), la conception des processeurs, la fabrication des puces, les infrastructures de calcul en nuage et les supercalculateurs. Ces filières sont à développer.

Outre l’augmentation des investissements, par exemple à travers les marchés publics, comme pour des applications d’IA dans les secteurs de la défense ou de la santé par exemple, Mc Kinsey invite à prendre pleinement position sur le marché des semi-conducteurs (via des technologies émergentes notamment), à lutter contre la fuite des cerveaux en assurant l’attraction des talents, et à former davantage aux métiers des différentes filières de l’IA, par des programmes de requalification de la main-d’oeuvre pour la préparer à ces nouveaux défis.

Les rapporteurs ont retenu de leurs comparaisons internationales qu’il faut commencer à lutter réellement contre la fuite des cerveaux. L’Inde et la Chine ont toutes deux compris l’importance pour leurs stratégies nationales en IA de retenir leurs talents et d’inciter au retour de leurs expatriés. En créant des écosystèmes compétitifs favorables à l’innovation, en offrant des opportunités de carrière attractives, en renforçant le sentiment national et surtout à travers divers dispositifs concrets, la France pourra suivre la voie ouverte par ces deux pays et limiter voire inverser la tendance à la fuite des cerveaux. Nous devons aller dans cette direction. Notre pays n’est pas un centre de formation destiné à préparer les futurs génies de la Silicon Valley.

7. Mettre en place une politique publique de l’IA avec des objectifs, des moyens et des outils de suivi et d’évaluation

Plutôt que d’annoncer une stratégie sans objectifs, sans gouvernance et sans outils de suivi, visant pourtant à « faire de la France un leader mondial de l’IA », il convient de mettre en place une véritable politique publique de l’IA avec des objectifs, des moyens réels dont une gouvernance digne de ce nom, et, enfin, des outils de suivi et d’évaluation. Ces éléments sont aujourd’hui cruellement absents des politiques publiques menées en France en matière d’intelligence artificielle.

Plus largement, la politique de la Start-up Nation avec son bras armé la French Tech, aussi élitiste qu’inadaptée, est à abandonner au profit d’une politique de souveraineté numérique, cherchant à construire notre autonomie stratégique et à mailler les territoires.

8. Organiser le pilotage stratégique de la politique publique de l’intelligence artificielle au plus haut niveau

La stratégie nationale pour l’IA ne dispose pas d’une gouvernance digne de ce nom et, comme l’ont montré les développements du présent rapport, le coordinateur national à l’intelligence artificielle ne représente qu’une toute petite équipe rattachée à un service de Bercy, la DGE. Il faudra, au moins, mieux coordonner la politique publique nationale de l’intelligence artificielle que nous appelons de nos voeux et lui donner une réelle dimension interministérielle avec un rattachement du coordinateur au Premier ministre.

La nomination d’une secrétaire d’État à l’intelligence artificielle et au numérique va dans le bon sens, mais il faut aller plus loin que ce premier pas symbolique et définir un pilotage stratégique de la politique publique de l’intelligence artificielle au plus haut niveau avec une coordination interministérielle.

9. Former les élèves de l’école à l’Université, former les actifs et former le grand public à l’IA

Il est indispensable de lancer de grands programmes de formation à destination des scolaires, des collégiens, des lycéens, des étudiants, des actifs et du grand public à l’IA. De ce point de vue, les politiques conduites par la Finlande, qui ont été présentées de manière détaillée, sont des modèles à suivre. La démystification de l’IA est une première étape importante et nécessaire pour permettre une adhésion à son développement. Elle favorisera aussi la diffusion de la technologie dans la société et dans nos entreprises. Et des programmes de formation de haut niveau permettront par ailleurs une montée en compétence en IA en France, qui dispose déjà d’atouts importants en la matière.

Il faut aussi promouvoir une vision scientifiquement éclairée et plutôt optimiste de l’intelligence artificielle, telle que celle portée par Yann LeCun par exemple, qui est l’un de nos plus grands experts de ces technologies. L’IA générale reste pour l’heure une perspective peu probable et la question des risques existentiels éventuellement posés par ces technologies n’est pas une priorité, même si elle fait écho aux représentations catastrophistes que le grand public se fait souvent de l’IA en lien avec les récits de science-fiction et le cinéma. Les rapporteurs, comme leurs prédécesseurs de 2017, jugent indispensable de démystifier l’intelligence artificielle.

10. Accompagner le déploiement de ces technologies dans le monde du travail et la société, notamment par la formation permanente

S’il est difficile de prévoir l’impact précis que l’IA aura sur le marché du travail, comme l’ont montré les développements à ce sujet dans le présent rapport, il faut tout de même accompagner le déploiement de ces technologies, notamment l’IA générative, dans le monde du travail, en particulier par des programmes de formation permanente ambitieux.

LaborIA s’intéresse aux aspects qualitatifs de ces transformations, mais il ne faut pas oublier les enjeux quantitatifs. C’est pourquoi il est recommandé de mener régulièrement des études qualitatives et quantitatives sur l’impact de l’IA sur l’emploi, le tissu social (dont les inégalités) et les structures cognitives en vue d’éclairer les pouvoirs publics et d’anticiper les mutations des pratiques professionnelles et les changements structurels dans les secteurs d’activité. Sur cette base, il sera possible d’ajuster plus efficacement les programmes de formation permanente et d’adapter les politiques publiques, par exemple en matière d’éducation, de recherche ou de soutien à l’innovation.

11. Lancer un grand dialogue social autour de l’intelligence artificielle et de ses enjeux

Le dialogue social par la négociation collective peut être renouvelé par l’introduction de cycles de discussions tripartites autour de l’IA et de ses nombreuses problématiques. Une opération d’envergure nationale, comme un Grenelle de l’IA, pourrait également être organisée.

Le dialogue social autour de l’IA devrait aussi se décliner dans les entreprises avec les salariés, les responsables des systèmes d’information et les DRH pour permettre une meilleure diffusion des outils technologiques et un rapport moins passionné à leurs conséquences. Comme le présent rapport l’a montré, c’est en effet une occasion de favoriser l’appropriation concrète et réaliste de la technologie et de ses enjeux, en se débarrassant des mythes entourant l’IA.

12. Mobiliser et animer l’écosystème français de l’IA

L’écosystème français de l’IA ne doit pas être mobilisé qu’à travers la French Tech, des meet-up à Station F et l’événement annuel VivaTech. Tous les acteurs de l’IA, la recherche publique et privée, les grands déployeurs de systèmes mais aussi l’ensemble des filières économiques via des correspondants IA (qui pourraient être des représentants des DSI par secteur) doivent pouvoir faire l’objet d’une grande mobilisation générale.

C’est un peu l’esprit qui avait régné entre décembre 2016 et mars 2017 lors de la préparation du plan France IA voulu par le Président de la République, alors François Hollande, un plan sans doute trop rapidement enterré au profit d’une stratégie de Start-up Nation dont les impasses et les lacunes apparaissent de plus en plus nettement avec le temps.

Il y manquait tout de même une structure d’animation, raison pour laquelle les rapporteurs suggèrent de mobiliser l’écosystème français de l’IA autour de pôles d’animation régionaux, en relation étroite avec les universités, les centres de recherche, comme Inria, et les entreprises. Des expériences étrangères ayant concrétisé l’approche initiale de France IA peuvent nous inspirer. La structure NL AI Coalition, créée par le gouvernement néerlandais et rencontrée par les rapporteurs à La Haye, rassemble ainsi depuis cinq ans l’écosystème public et privé de l’IA aux Pays-Bas, avec le concours du patronat, des universités et des grands centres de recherche. Elle s’appuie sur sept centres régionaux et est organisée en 18 groupes de travail thématiques.

13. Reconduire le programme « Confiance.ai » ou mettre en place un projet équivalent

Le programme « Confiance.ai » s’est interrompu en 202.4 alors qu’il ne coûtait pas cher et était efficace Il visait à permettre aux industriels d’intégrer des systèmes d’IA de confiance dans leurs process grâce à des méthodes et des outils intégrables dans tout projet d’ingénierie.

Pour ce faire, le programme levait les verrous associés à l’industrialisation de l’IA comme la construction de composants de confiance maîtrisés, la construction de données et/ou de connaissances pour augmenter la confiance dans l’apprentissage ou encore l’interaction générant de la confiance entre l’utilisateur et le système fondé lui-même sur l’IA de confiance. Il réunissait dans une logique partenariale de grands acteurs académiques et industriels français dans les domaines critiques de l’énergie, la défense, des transports et de l’industrie 4.0 comme l’illustre ce graphique.

Les partenaires du programme Confiance.ai

Le programme visait la construction d’une plateforme sûre, fiable et sécurisée d’outils logiciels, qui soit à la fois souveraine, ouverte, interopérable et pérenne dans les secteurs des produits et services critiques les plus concernés, mutualisant les savoir-faire scientifiques et technologiques et contribuant au cadre technique du règlement européen sur l’intelligence artificielle. Dans ce contexte, il est demandé au gouvernement et, en particulier, à la DGE de reconduire le programme « Confiance.ai » ou de mettre très rapidement en place un projet équivalent capable d’allier des expertises en termes de technologie, d’évaluation et de normalisation de l’intelligence artificielle.

Son coût d’environ 3,75 millions d’euros par an est à mettre en regard des 37 milliards d’euros de dépenses proposés par la commission sur l’intelligence artificielle en 2024. Le programme « Confiance.ai » n’en représentait que 1 %, or au vu de ses actions et de ses résultats, il justifie la poursuite d’un effort budgétaire raisonnable et pourtant rentable.

14. Soutenir la recherche publique en intelligence artificielle selon des critères de transversalité et de diversification des technologies

La recherche privée en intelligence artificielle a pris beaucoup d’avance sur la recherche publique, mais cette dernière doit revenir dans la course. La soutenir davantage est un impératif. L’Office juge pertinent de l’orienter vers des activités transdisciplinaires et, plus globalement, transversales autour de « projets de recherche » en IA.

La préoccupation à l’égard de la diversification des technologies est aussi fondamentale : les avancées en IA se font par la combinaison et la recomposition de savoirs et de savoir-faire, pas par l’enfermement dans un modèle unique que l’on chercherait à perfectionner. L’IA générative, à travers son modèle Transformer, ne doit pas devenir la priorité du monde de la recherche, en dépit de l’effet de mode autour de ChatGPT.

L’IA symbolique, par exemple, ne doit pas être totalement abandonnée, elle peut s’hybrider avec les IA connexionnistes pour forger de nouvelles approches logiques, imbriquant le signifiant et le signifié et, partant, plus proches des raisonnements humains. D’autres technologies permettant d’apporter plus de logique aux systèmes d’IA générative peuvent également inspirer de nouvelles perspectives pour la recherche, comme les modèles « Mixture of Experts » (MoE), les arbres de pensées ou Trees of Thoughts (ToT) et la génération augmentée de récupération ou Retrieval Augmented Generation (RAG).

La prise en compte de modèles de représentation du monde (« World Models ») dans de nouvelles « architectures cognitives » est un autre défi que la recherche devra relever, permettant aux IA de prendre en compte la réalité spatio-temporelle, y compris le monde physique et ses lois.

Pour paraphraser Rabelais qui écrivait que « Science sans conscience n’est que ruine de l’âme », les rapporteurs affirment que « l’IA sans logique n’est qu’illusion d’intelligence ».

15. Relever le défi de la normalisation en matière d’intelligence artificielle

Il faut permettre à la France de défendre au mieux l’intérêt national ainsi que les intérêts de nos entreprises nationales en matière de normalisation de l’IA, ce qui implique de mobiliser davantage l’Afnor et surtout le Cofrac, aujourd’hui désinvesti sur ce sujet.

Il faudrait aussi maintenir ou augmenter le financement de nos organismes de normalisation qui remplissent leurs missions dans des conditions parfois difficiles.

Enfin, la France doit inviter ses partenaires européens à faire preuve d’une plus grande vigilance dans le choix de leurs représentants dans les comités chargés de la normalisation en IA : s’appuyer sur des experts issus d’entreprises extra-européennes, le plus souvent américaines ou chinoises, n’est pas acceptable.

16. S’assurer du contrôle souverain des données issues de la culture française et des cultures francophones et créer des jeux de données autour des cultures francophones

Il faut à la fois s’assurer du contrôle souverain des données issues de la culture française, notamment des archives détenues par la BNF ou l’Institut national de l’audiovisuel, voire des cultures francophones et créer des datasets autour des cultures francophones, en vue d’alimenter l’entraînement de modèles d’IA reflétant notre environnement linguistique et culturel.

Il s’agit d’un acte de résistance face à la domination linguistique et culturelle anglo-saxonne, en particulier américaine, qui caractérise l’IA aujourd’hui et qui fait courir un risque grave d’uniformisation culturelle et d’appauvrissement linguistique. Les jeux de données autour des cultures francophones pourront être constitués avec le concours de tous les pays de la francophonie.

Les initiatives conduites par certains pays, en particulier par l’Espagne, peuvent contribuer à inspirer notre pays et à aider à la définition du cadre de ces datasets. En effet, le gouvernement espagnol a lancé depuis 2022 un plan national autour de la « nouvelle économie de la langue ». Il vise à placer l’espagnol au coeur de la transformation numérique et de la promotion de la chaîne de valeur de la nouvelle économie de la connaissance et de l’intelligence artificielle.

La France doit faire la même chose pour le français. Ainsi, le plan de l’Espagne se décline notamment en constitution de bases de données textuelles dans les langues espagnoles, ces datasets, permettant l’entraînement de modèles et la création de LLM basés sur la langue et la culture espagnoles.

Comme l’Espagne, qui a réservé une part de son plan à ses langues « co-officielles » (catalan, basque, galicien) à côté de l’espagnol, la France pourrait avantageusement consacrer une part de ces jeux de données autour des cultures francophones aux langues régionales (breton, occitan, basque, corse, langues pratiquées dans les territoires ultramarins…) dont l’appartenance au patrimoine national a été consacrée par la Constitution depuis 2008.

17. Préparer une réforme des droits de propriété intellectuelle dont le droit d’auteur pour les adapter aux usages de l’IA générative

Il faut poser les bases d’une réforme des droits de propriété intellectuelle et du droit d’auteur pour les adapter aux usages de l’IA générative et aux problèmes posés plus généralement par l’utilisation de l’intelligence artificielle.

Notre législation en matière de propriété intellectuelle et de droits d’auteur applicables à l’IA générative nécessite à l’évidence plusieurs éclaircissements. Le rapport d’information de la commission des lois de l’Assemblée nationale déposé en conclusion des travaux de sa mission d’information sur les défis de l’intelligence artificielle générative en matière de protection des données personnelles et d’utilisation du contenu généré s’est consacré à ce travail de clarification.

L’objectif d’une telle réforme sera à la fois de clarifier les régimes juridiques applicables, de protéger les ayants droit des données ayant servi à l’entraînement des modèles mais aussi les créateurs d’oeuvres nouvelles grâce à l’IA.

Cela impliquera donc, d’une part, de trancher l’épineuse question de l’équilibre entre les intérêts des ayants droit et intérêt des entreprises développant des modèles d’intelligence artificielle, d’autre part, de lever le doute sur la frontière entre oeuvre originale et contrefaçon ou copie dans le cas d’un travail créé par IA puisque la réforme devra aussi mettre fin au flou juridique entourant le statut des oeuvres créées par l’intelligence artificielle.

La solution des droits voisins, utilisée dans les secteurs de la musique et du cinéma, mais aussi de l’information (dont la presse écrite) à la suite des transformations liées au numérique et à Internet, est une perspective dont il faut débattre.

Face au succès des plateformes de streaming et de service de vidéo à la demande, l’enjeu de ces compensations financières devient grandissant. Il le sera encore plus avec la diffusion de l’IA. L’UE s’est d’ailleurs dotée en 2019 d’une directive sur le droit d’auteur et les droits voisins dans le marché unique numérique, qu’il faudra faire évoluer au rythme des capacités de création de l’IA.

Techniquement, l’utilisation de données propriétaires et surtout de contenus protégés par le droit d’auteur peut non seulement être limitée en amont par le nettoyage des données mais dorénavant corrigée en aval grâce à une nouvelle technologie introduite récemment appelée Model disgorgement ou Machine Unlearning.

Les entreprises qui collecteraient illégalement des données pour les utiliser à fin d’entraînement de leurs modèles pourraient par exemple être dans l’obligation non seulement de supprimer les données problématiques et de les abandonner lors de futurs entraînements mais surtout de mettre à jour leurs modèles en faisant comme si ces données n’avaient jamais été utilisées. Plutôt que de réentraîner totalement leurs modèles, les entreprises s’appuieraient alors utilement sur cette technique émergente qui pourra encore être perfectionnée.

18. Confier à l’OPECST le suivi et l’évaluation régulière de la politique publique conduite par le Gouvernement en la matière

La politique nationale en matière d’IA conduite par le Gouvernement devrait faire l’objet d’un suivi et d’une évaluation régulière par l’OPECST. Les aspects scientifiques et technologiques de l’intelligence artificielle ainsi que les enjeux qu’ils soulèvent appellent une expertise et une vigilance à la croisée des mondes politiques et scientifiques, c’est donc logiquement à l’OPECST qu’il convient de faire appel.

Dans le rapport précité de la commission des lois de l’Assemblée nationale, nos collègues députés – ayant constaté que le premier travail parlementaire relatif à l’IA avait été fait dans le rapport de l’OPECST de mars 2017 « Pour une intelligence artificielle maîtrisée, utile et démystifiée », qualifié « d’étude approfondie » – préconisent dans leur 33e recommandation de confier à l’OPECST un suivi permanent des questions relatives à l’intelligence artificielle.

LA GOUVERNANCE EUROPÉENNE DE L’INTELLIGENCE ARTIFICIELLE

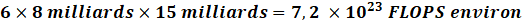

Les réflexions menées au sein de l’UE en termes de régulation de l’IA depuis quatre ans sont très proches de celles conduites par l’OCDE. Mais l’encadrement européen des systèmes d’IA ne se limite pas au régime spécifique les concernant. Le droit de l’Union européenne prévoit en effet différentes dispositions concernant les outils numériques qui peuvent impacter les systèmes d’intelligence artificielle. Depuis le 13 juin 2024, un règlement est totalement consacré à l’encadrement de l’IA ; il s’ajoute à de nombreuses autres dispositions.

Les textes sont très nombreux, parfois d’application sectorielle, il est donc difficile de tous les récapituler ici. Pour mémoire, les plus récents et les plus transversaux viennent compléter le règlement général sur la protection des données (RGPD) du 27 avril 2016 et s’insèrent dans la « Stratégie numérique pour l’Europe pour la décennie 2020-2030 » : à l’instar du règlement sur les marchés numériques du 14 septembre 2022 (dit « DMA », pour Digital Markets Act, empêchant notamment les géants du numérique de privilégier leurs services sur leurs plateformes en laissant chacun choisir librement son moteur de recherche, son navigateur ou sa messagerie) ; du règlement sur les services numériques du 19 octobre 2022 (dit « DSA », pour Digital Services Act, qui responsabilise les plateformes en rendant illégal en ligne ce qui est illégal hors ligne, comme les contenus illicites, et dont l’esprit se retrouve dans la loi du 21 mai 2024 visant à sécuriser et à réguler l’espace numérique (dite loi « SREN ») en interdisant – en ligne – les arnaques, la haine, la désinformation et la publicité ciblée sur les mineurs ou encore en protégeant les mineurs de la pornographie ; du règlement sur la gouvernance des données du 30 mai 2022 ; du règlement sur la cybersécurité du 17 avril 2019, de la directive sur la cybersécurité du 14 décembre 2022 et du règlement sur la cybersécurité du 13 décembre 2023 ; du règlement du 12 mars 2024 sur la cyberrésilience, etc.

Dans ce contexte foisonnant, il est important de noter qu’en 2024, au terme de plusieurs années de travail préparatoire, un cadre visant spécifiquement les systèmes d’intelligence artificielle a été adopté à travers le règlement du 13 juin 2024 établissant des règles harmonisées concernant l’intelligence artificielle, communément dénommé AI Act. Il fait l’objet d’une application progressive d’ici à 2026 avec des règles harmonisées applicables à la mise sur le marché, à la mise en service et à l’utilisation de systèmes d’IA.

Présenté par l’Union européenne comme « premier texte législatif de ce type au monde », cette réglementation, qui se veut pionnière, a donc vocation à devenir un standard mondial concernant la mise sur le marché, la mise en service et l’utilisation de ces systèmes dans le but de garantir que l’IA soit une technologie « axée sur l’humain » et que les systèmes d’IA soient « sûrs, éthiques et dignes de confiance ».

Comme l’assure l’exposé des motifs du projet de règlement, l’AI Act vient compléter le droit de l’Union et ne le remplace pas, en particulier en ce qui concerne les droits fondamentaux ; la protection de la vie privée, des données, des consommateurs et des travailleurs ; l’emploi ; la sécurité des produits. Les droits et les recours existants pour les personnes sur lesquelles les systèmes d’IA sont susceptibles d’avoir des incidences négatives demeurent inchangés et pleinement applicables. L’intelligence artificielle ne suspend pas le droit en vigueur.

1. Le travail préparatoire conduit par les institutions européennes entre 2018 et 2020

La construction des bases de la gouvernance européenne en matière d’intelligence artificielle s’est d’abord appuyée sur trois principales contributions : une communication de la Commission européenne en avril 2018, les différentes recommandations d’un groupe d’experts placé auprès de la Commission européenne en 2019 puis un Livre blanc de la Commission en 2020.

a) La communication de la Commission européenne d’avril 2018

La Commission européenne a tout d’abord publié en avril 2018 une communication pour l’intelligence artificielle en Europe. Elle appelait à la mise en place d’un cadre éthique et juridique conforme aux valeurs de l’Union européenne et à la Charte des droits fondamentaux, mais sans préconiser la création d’une législation contraignante spécifique à l’intelligence artificielle. Au lieu de cela, la communication attirait l’attention sur les cadres juridiques existants (la protection des données personnelles avec le RGPD de 2016, les règles relatives à la sécurité des produits et les régimes de responsabilité civile ordinaires).

Sur la base de cette première communication, un travail de coordination a été conduit avec les États membres et la Norvège en vue d’aboutir rapidement à un plan coordonné pour l’IA en Europe. Le 7 décembre 2018, la Commission européenne a publié une communication sur les objectifs et les initiatives d’un plan coordonné dans le domaine de l’intelligence artificielle, plan actualisé en 2021.

b) Le groupe d’experts de haut niveau sur l’IA

Dans la perspective de ses futurs travaux sur l’IA, la Commission européenne avait entretemps nommé en juin 2018 un groupe d’experts de haut niveau sur l’IA (high-level experts group on artificial intelligence ou HLEG AI en anglais).

Ce groupe était composé d’experts des milieux industriels et scientifiques et présidé par Pekka Ala-Pietilä, président du conseil d’administration de Huhtamaki, Sanoma et Netcompany et ex-président de Nokia ainsi que docteur honoraire en technologie à l’université de Tampere en Finlande. Le groupe devait élaborer des conclusions permettant de guider l’action de la Commission ainsi que des colégislateurs en matière d’IA. Pour ce faire, il a d’abord publié en décembre 2018 une définition de la notion d’IA, qui lui a permis de circonscrire le périmètre de ses travaux.

Cette définition reprend et étend la définition de la précédente communication de la Commission :

« L’intelligence artificielle (IA) désigne les systèmes qui font preuve d’un comportement intelligent en analysant leur environnement et en prenant des mesures – avec un certain degré d’autonomie – pour atteindre des objectifs spécifiques. Les systèmes dotés d’IA peuvent être purement logiciels, agissant dans le monde virtuel (assistants vocaux, logiciels d’analyse d’images, moteurs de recherche ou systèmes de reconnaissance vocale et faciale, par exemple) mais l’IA peut aussi être intégrée dans des dispositifs matériels (robots évolués, voitures autonomes, drones ou applications de l’internet des objets, par exemple). »

Sur la base de cette définition, le HLEG AI a mis au point plusieurs livrables thématiques pour permettre à la Commission européenne de travailler sur la base de définitions et d’objectifs clairement établis.

Le premier livrable, publié en avril 2019, fixe les lignes directrices en matière d’éthique de l’IA qui permettraient d’arriver à une « IA digne de confiance ». Le groupe considère que pour qu’une technologie d’IA soit considérée comme « digne de confiance », il lui faut réunir au moins trois de ces éléments :

– être licite (respecter les législations et réglementations existantes) ;

– être éthique, et assurer l’adhésion à des principes et valeurs éthiques ;

– être équitable, diverse et non discriminatoire ;

– être transparente ;

– permettre un contrôle humain ;

– être robuste techniquement et socialement et sécurisée ;

– être robuste pour ne pas causer de préjudices involontaires ;

– respecter la vie privée et la gouvernance des données ;

– participer au bien-être social et environnemental ;

– savoir qui est responsable sur toute la chaîne de valeur.

Ces exigences sont proches de celles préconisées par l’OCDE pour la mise en place d’une IA éthique.

Le second livrable du HLEG AI est une liste de recommandations en matière de politiques publiques et d’investissements, avec le même objectif de garantir une « IA de confiance ». Le document formule 33 recommandations pour orienter l’IA vers la durabilité, la croissance, la compétitivité et l’action.

Les investissements doivent s’appuyer sur quatre bases : le secteur privé, le secteur public, la société civile et la recherche. Le groupe identifie huit leviers que les pouvoirs publics peuvent utiliser pour développer le potentiel de l’IA : l’éducation et la formation, la gouvernance et la régulation, le financement et l’investissement, le secteur privé, la société civile, le secteur public, la recherche ainsi que les données et l’infrastructure.

Ce document fait apparaître l’approche pluridisciplinaire que retient l’Union européenne : plutôt que de réguler un secteur en particulier, le HLEG AI estime que l’investissement doit être transversal et intégré.

Après la publication de ces deux premiers livrables, le groupe a mis en place un outil pratique d’évaluation qui permet de traduire les lignes directrices en techniques d’autoévaluation.

Enfin, le HLEG AI a réalisé un dernier livrable concernant une approche sectorielle de politiques publiques et d’investissement pour l’IA.

Ce dernier livrable était particulièrement destiné à l’Alliance européenne pour l’IA (European AI Alliance), une coalition créée par la Commission européenne en 2018 dans le but « d’ouvrir le dialogue sur l’intelligence artificielle ». Cette alliance est composée de 6 000 parties prenantes de la société civile européenne (citoyens, représentants des consommateurs et des entreprises, syndicats, établissements de recherche, autorités et experts).

Après la publication de ce dernier livrable, le mandat de l’AI HLEG est arrivé à son terme en juillet 2020 et seule l’Alliance a continué ses activités.

c) Le Livre blanc de la Commission européenne sur l’IA

La phase de consultation des experts et de la société civile organisée par les institutions européennes a été conclue par la publication par la Commission européenne d’un Livre blanc sur l’IA de 30 pages sous-titré « Une approche européenne axée sur l’excellence et la confiance » en février 2020. Il a été soumis à consultation publique jusqu’au 19 mai 2020 et discuté lors de la deuxième assemblée de l’Alliance européenne pour l’IA en octobre 2020.